DLL-Toolboard

EvaExam Scan - Aufgaben-Analyse

Inhaltsübersicht

1.1. Item-Analyse im Gesamt-Report

1.2. Item-Analyse in der Fragenbibliothek

Item-Analyse [Bearbeiten]

Prüfungsergebnisse liefern, neben den Ergebnissen zu Lernständen der Studierenden, auch Erkenntnisse zur Qualität der Aufgabenkonstruktion durch Lehrende. Diese Infomationen können Lehrende nutzen, um die Aufgabenqualität künftig zu optimieren. Für Single Choice-,Multiple Choice- und Zuordnungsfragen können Werte für die Schwierigkeit berechnet werden. Hierfür ist es besonders aufschlussreich, gleiche Aufgaben über verschiedene Kohorten, Semester etc. zu analysieren.

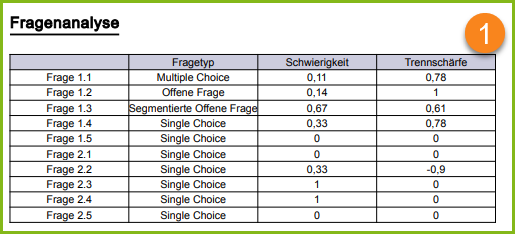

Item-Analyse im Gesamt-Report

Die PDF Gesamt-Reporte beinhalten im Kapitel "Gesamtbericht + Fragenanalyse" eine automatische Analyse der Aufgaben-Trennschärfe und -Schwierigkeit für die aktuelle Prüfung (1).

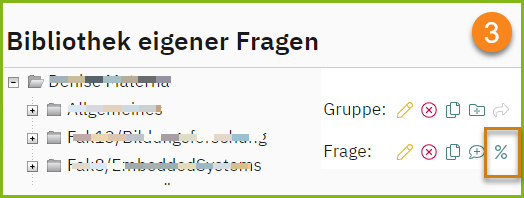

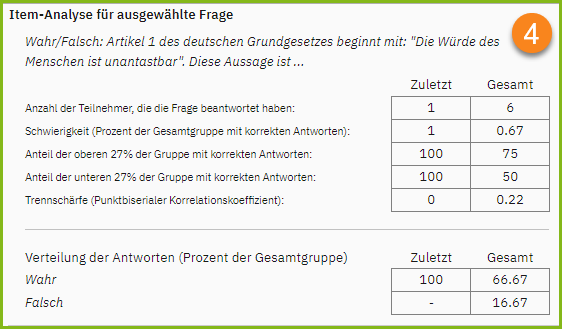

Item-Analyse in der Fragenbibliothek

Die Arbeit mit der Fragenbibliothek ermöglicht eine Analyse der Aufgaben-Trennschärfe und -Schwierigkeit über einen längeren Zeitraum. Außerdem kann eine zufällige Auswahl an Fragen für einen Prüfungsbogen anhand der automatisch berechneten Trennschärfen oder Schwierigkeiten aus vorangegangenen Prüfungen vorgenommen werden. In den Details einer Prüfung muss dazu [Ergebnisse zur Item-Analyse freigeben] gewählt werden (2). Damit werden für Multiple-Choice, Single-Choice und Zuordnungsfragen, die mit der Fragenbibliothek verknüpft sind, sowohl der berechnete Schwierigkeitsgrad als auch die berechnete Trennschärfe hinterlegt und können über die Fragenbibliothek aufgerufen werden (3). Der Bericht zeigt die letzte Prüfung und die Gesamtheit der Beantwortungen (4). In je mehr Prüfungen diese Fragen verwendet und erneut zur Item-Analyse freigegeben werden, desto genauer und aussagekräftiger werden die berechneten Werte.

Achtung, wenn Änderungen an einer Frage vorgenommen werden, wirken sich diese auf die Analyse aus, so dass diese voraussichtlich nicht mehr aussagekräftig ist. Es empfiehlt sich für Änderungen die Aufgabe neu anzulegen, zu kopieren etc., damit sich zukünftige Analysen auf die angepasste Frage beziehen.

Aufgabenschwierigkeit [Bearbeiten]

Berechnet sich als Anteil der Personen, die eine Aufgabe richtig beantwortet haben in Prozent (0.75= 75%). Die Analyse getrennt nach Leistungsgruppen (je obere und untere 27%) liefert zusätzliche Informationen. Die Schwierigkeit einer Aufgabe sollte in höheren Leistungsgruppen (bemessen am Gesamtergebnis) abnehmen, Personen mit guter Leistung sollten die Aufgabe also häufiger korrekt lösen. Eine Klassifikation von Aufgaben, z.B. als schwer, mittel und leicht kann bei der (zukünftigen) Zusammenstellung von Prüfungen helfen. Vor allem können zu schwere und zu leichte Aufgaben identifiziert und auf Konstruktionsfehler geprüft werden.

| Interpretation | Multiple-Choice/Kprim | Single-Choice/Wahr-Falsch | Zuordnung |

| Einfach | 0.75-1.0 | 0.85-1.0 | 0.75-1.0 |

| Mittel | 0.60-0.75 | 0.65-0.85 | 0.50-0.75 |

| Schwer | >0.60 | >0.65 | >0.50 |

Aufgabentrennschärfe [Bearbeiten]

Berechnet als Punktbiserialer Korrelationskoeffizient zwischen der Antwortrichtigkeit in der untersuchten Aufgabe und dem Gesamtergebnis der Prüfung. Korrelationswerte liegen grundsätzlich zwischen -1 und 1. Eine positive Korrelation (>.30) spricht für eine hinreichende Differenzierung der Aufgabe zwischen Personen mit mehr und weniger Wissen. Der Wert reflektiert aber auch die Repräsentativität der Aufgabe für die Prüfungsleistung (d.h. inwiefern spiegelt sich die Gesamtleistung der Studierenden in der untersuchten Aufgabe wieder). Diese Interpretation ist im Kontext heterogener Prüfungsaufgaben jedoch mit Vorsicht zu betrachten. Grundsätzlich sind niedrige Trennschärfen immer ein Hinweis auf ein Konstruktionsfehler der Frage, z.B. eine uneindeutige Fragestellung, eine oder mehrere strittige Lösungen oder auch eine versehentlich falsche Bepunktung.

| Interpretation | Multiple-Choice/Kprim | Single-Choice/Wahr Falsch | Zuordnung |

| Hoch | 0.3-1.0 | 0.2-1.0 | 0.3-1.0 |

| Mittel | 0.15-0.3 | 0.1-0.2 | 0.15-0.3 |

| Gering | >0.3 | >0.1 | >0.15 |